[unable to retrieve full-text content]

(Bild: Maksim Shmeljov/Shutterstock.com)

Japan hat seine Pole-Position in der Chipproduktion seit den 1990er-Jahren verloren. Doch ein Großprojekt soll das ändern.

Die japanische Regierung hat ehrgeizige Pläne, um das Land wieder zu einem führenden Standort für die Chipproduktion zu machen. Anfang des Monats erhöhte sie die Subventionen für das Start-up Rapidus um 3,3 Milliarden auf etwa 6 Milliarden Euro. Das Investitions-Projekt gilt als einer der gewagtesten Versuche für eine technologische Aufholjagd, da Japan damit mehrere Chipgenerationen überspringen will.

Das Land ist zwar laut einer Analyse des Aktienhauses Morgan Stanley MUFG mit einem Anteil von 20 Prozent an der weltweiten Chipproduktion eine der größten Herstellernationen für Halbleiter. Doch dabei handelt es sich ausschließlich um alte Technologien mit Strukturen im zweistelligen Nanometerbereich. Moderne Chips stammen inzwischen zum großen Teil von TSMC aus Taiwan [1].

Das 2022 von japanischen Unternehmen wie Toyota und dem Technikkonzern NEC gegründete Rapidus [2] will hingegen Chips mit 2-Nanometer-Strukturen fertigen und damit zu den technologischen Weltmarktführern TSMC, Samsung aus Südkorea und Intel aufschließen.

Experten der US-Denkfabrik Center for International & Strategic Studies sehen darin "eine beispiellose technologische Leistung", wenn es den Japanern denn gelingt. Die Voraussetzungen sind so gut, wie sie nur sein können. Rapidus arbeitet eng mit anderen Unternehmen zusammen. Expertise bei fortschrittlicher Fertigungstechnik und Chipdesign stammt von IBM [3], die Belichtungstechnik von Imec in Belgien, während die Japaner letztlich die Produktionstechnik entwickeln. Trotzdem ist das Ganze alles andere als ein einfaches Unterfangen – es gilt, weit mehr als ein Jahrzehnt Entwicklungsrückstand aufzuholen.

Für Japans Regierung wäre es die Krönung ihrer Strategie, die Chipindustrie der einst führenden Halbleiternation wiederzubeleben. In den 1980er- und 1990er-Jahren stammten mehr als die Hälfte aller Computerchips aus der ältesten Industrienation Asiens. Doch als die Chipproduktion mit dem Start der digitalen Epoche und dann erst recht mit Smartphones richtig losging, konnten die Elektronikkonzerne beim Investitionswettrennen nicht mit ihren asiatischen Rivalen mithalten.

Zum einen war Japans Chipindustrie zu fragmentiert und damit die Sparten der Konzerne jede für sich zu klein. Zum anderen steckten viele Konzerne in Krisen und waren daher finanziell klamm, während Taiwan und Südkorea lokale Chipfertiger stark subventioniert haben. Daher überlebte die japanische Produktion nur in Nischen.

Toshibas ehemalige Speicherchip-Sparte leistet nun als Kioxia Samsung und SK Hynix Konkurrenz. Renesas, eine Auffanggesellschaft für die Chipsparten mehrerer Unternehmen, baut Chips für automobile und industrielle Anwendungen. Darüber hinaus sind die Japaner auch bei Sensoren stark, insbesondere bei Bildsensoren für Kameras und Smartphones. Zudem konnten die Hersteller von Anlagen, Bauteilen und Chemikalien bisher ihre starke Stellung in der globalen Chiplieferkette verteidigen.

Ende des vorigen Jahrzehnts beschloss die Regierung dann, die überlastete eigene Chipindustrie als Grundlage für eine industrielle Aufholjagd zu nutzen. Der Grund: Der wachsende Großmachtkonflikt zwischen China und den USA sowie Chinas Drohung, die Chip-Hochburg Taiwan anzugreifen, schürte die Angst, dass die Chip-Lieferungen für die eigene Industrie abreißen könnten.

Japans Ministerium für Wirtschaft, Handel und Industrie (METI) ging bei ihrer Wiederbelebungsstrategie sehr strategisch vor. Im Gegensatz zur Europäischen Union oder den USA verzichtete die japanische Regierung darauf, große Subventionspakete in Höhe von Milliarden Euro zu versprechen. Stattdessen werden staatliche Beihilfen projekt- und schrittweise vergeben. Zudem verfolgte die Regierung eine Etappenstrategie.

Zuerst konzentrierte sich das Ministerium darauf, TSMC zum Bau von Werken für relativ große Chips zu gewinnen [4], die Japans Industrie hauptsächlich benötigt. Damit wollten die Wirtschaftsplaner dafür sorgen, dass es für die Chips auch wirklich einen Absatzmarkt gibt.

Die Japaner überzeugten die Taiwaner sogar davon, mit dem Elektronikkonzern Sony und dem Automobilzulieferer Denso ein Joint Venture zu gründen. Dieses Modell steht auch für das Engagement von TSMC in Dresden [5] Pate.

Der Aufbau der ersten Fabrik, die Anfang des Jahres eingeweiht wurde, lief sogar so glatt, dass TSMC bereits ein zweites Werk plant. Dort sollen 6-Nanometer-Chips für autonomes Fahren hergestellt werden. Gerüchten zufolge denken die Taiwaner sogar über ein drittes Werk nach.

Der frühe Erfolg der Ansiedlungsstrategie stärkte die Bereitschaft der Wirtschaftsplaner, mit Rapidus eine wirklich große technologische Wette zu wagen. Die Regierung ist sich sehr wohl bewusst, dass dies Japans letzte Chance ist, mit einem japanischen Unternehmen in der Weltspitze mitzuspielen. METI-Minister Ken Saito sagte daher im vergangenen Jahr: "Das Projekt darf auf keinen Fall scheitern."

URL dieses Artikels:

https://www.heise.de/-9680421

Links in diesem Artikel:

[1] https://www.heise.de/thema/TSMC

[2] https://www.heise.de/news/Halbleiter-Wettrennen-Japan-gruendet-Rapidus-fuer-neue-2-Nanometer-Fertigung-7337319.html

[3] https://www.heise.de/thema/IBM

[4] https://www.heise.de/news/TSMC-Werke-Japan-subventioniert-angeblich-40-Prozent-9637437.html

[5] https://www.heise.de/news/TSMC-kommt-als-ESMC-nach-Deutschland-9237991.html

[6] https://www.instagram.com/technologyreview_de/

[7] mailto:jle@heise.de

Copyright © 2024 Heise Medien

(Bild: artjazz/Shutterstock.com)

Der EU-Politiker Dragoş Tudorache glaubt, dass die KI-Verordnung, an deren Verabschiedung er mitgewirkt hat, den KI-Sektor zum Besseren verändert.

Dragoş Tudorache hat derzeit viel Grund zur Freude. Er sitzt in einem Konferenzraum in einem Chateau mit Blick auf einen See außerhalb von Brüssel und schlürft ein Glas Cava. Der liberale Abgeordnete des Europäischen Parlaments hat den Tag damit zugebracht, einer Konferenz über KI, Verteidigung und Geopolitik vorzustehen, an der fast 400 VIP-Gäste teilgenommen haben.

Der ehemalige rumänische Innenminister gilt als einer der wichtigsten Akteure in der europäischen KI-Politik. Er war einer der beiden federführenden Verhandlungsführer für den AI Act im Europäischen Parlament [1]. Die Verordnung, die weltweit erste umfassende KI-Gesetzgebung ihrer Art, wird noch in diesem Jahr in Kraft treten. Vor zwei Jahren wurde er in seine Position berufen.

Das Interesse an KI begann jedoch bei ihm schon viel früher, im Jahr 2015. Er sagt, die Lektüre von Nick Bostroms Buch "Superintelligenz" [2] habe ihn geprägt. Darin wird geschildert, wie eine allgemeine Künstliche Intelligenz geschaffen werden könnte und welche Auswirkungen diese haben könnte. Das Werk habe ihm das Potenzial und die Gefahren der KI und die Notwendigkeit ihrer Regulierung vor Augen geführt. (Bostrom selbst ist derzeit in einen Skandal verwickelt [3], weil er in E-Mails aus den Neunzigerjahren rassistische Ansichten geäußert haben soll. Tudorache sagt, er wisse nichts über die weitere Karriere des Philosophen nach der Veröffentlichung des Buches.) Als Tudorache dann 2019 in das Europäische Parlament gewählt wurde, war er entschlossen, an der Regulierung von KI zu arbeiten, wenn sich die Gelegenheit bieten würde.

"Als ich [Ursula] von der Leyen in ihrer ersten Rede vor dem Parlament sagen hörte, dass es eine KI-Regulierung geben wird, sagte ich: 'Juhu, das ist mein Moment'", erinnert er sich. Seitdem hat Tudorache den Vorsitz des Sonderausschusses für KI inne und den AI Act durch das Europäische Parlament und in seine endgültige Form nach Verhandlungen mit anderen EU-Institutionen gebracht.

Es war ein wilder Ritt, mit intensiven Verhandlungen, dem Aufstieg von ChatGPT, der Lobbyarbeit von Technologieunternehmen [4] und einem Hin und Her einiger der größten europäischen Volkswirtschaften. Doch nun, da der AI Act verabschiedet wurde, ist Tudoraches Arbeit daran erledigt und er sagt, dass er es nicht bereut. Obwohl das Gesetz kritisiert wurde – sowohl aus der Zivilgesellschaft, weil es die Menschenrechte nicht ausreichend schützen soll, als auch von der Industrie, die es für zu restriktiv hält – sagt Tudorache, dass die endgültige Form die Art von Kompromiss war, die er erwartet hatte. Politik sei nun einmal die Kunst des Kompromisses.

"Es wird viel an dem Flugzeug herumgebastelt, während es in der Luft ist, und wir lernen viel von diesem Flug", sagt er. "Aber wenn der wahre Geist dessen, was wir mit der Gesetzgebung gemeint haben, von allen Beteiligten gut verstanden wird, glaube ich, dass das Ergebnis positiv ausfallen kann." Es sei aber noch zu früh – das Gesetz tritt erst in zwei Jahren vollständig in Kraft. Tudorache ist jedoch davon überzeugt, dass es die Technologiebranche zum Besseren verändern und einen Prozess in Gang setzen wird, bei dem die Unternehmen beginnen, verantwortungsvolle KI ernst zu nehmen, da die KI-Unternehmen rechtlich verpflichtet sind, transparenter zu machen, wie ihre Modelle aufgebaut sind.

"Die Tatsache, dass wir jetzt eine Blaupause dafür haben, wie man die richtigen Grenzen setzt und gleichzeitig Raum für Innovationen lässt, ist etwas, das der Gesellschaft dienen wird", sagt Tudorache. Es wird auch den Firmen nützen, weil es einen vorhersehbaren Weg bietet, was man mit KI anstellen darf und was nicht. Aber das KI-Gesetz ist erst der Anfang, und es gibt noch vieles, was Tudorache nachts wach hält. KI werde in allen Branchen und in der gesamten Gesellschaft große Veränderungen herbeiführen. [5]

Sie wird seiner Ansicht nach alles verändern, von der Gesundheitsversorgung über Bildung, Arbeit und Verteidigung bis hin zur menschlichen Kreativität. Die meisten Länder haben noch nicht begriffen, was KI für sie bedeuten wird, sagt Tudorache, und es liegt nun in der Verantwortung der Regierungen, dafür zu sorgen, dass die Bürger und die Gesellschaft im weiteren Sinne für das KI-Zeitalter bereit sind. "Die Crunchtime beginnt jetzt", sagt er.

URL dieses Artikels:

https://www.heise.de/-9678623

Links in diesem Artikel:

[1] https://www.heise.de/news/AI-Act-Mitgliedstaaten-stimmen-Kompromiss-einstimmig-zu-9617206.html

[2] https://www.heise.de/hintergrund/Unsere-letzte-Erfindung-3152050.html

[3] https://www.vice.com/en/article/z34dm3/prominent-ai-philosopher-and-father-of-longtermism-sent-very-racist-email-to-a-90s-philosophy-listserv

[4] https://www.heise.de/news/KI-Regulierung-Wie-Google-und-Microsoft-Stimmung-gegen-den-AI-Act-machen-7531687.html

[5] https://www.heise.de/hintergrund/Arbeit-Bildung-Kunst-Wie-grosse-KI-Modelle-unsere-Gesellschaft-veraendern-8987587.html

[6] https://www.instagram.com/technologyreview_de/

[7] mailto:jle@heise.de

Copyright © 2024 Heise Medien

(Bild: Shutterstock/Phonlamai Photo)

In einer Studie überzeugte GPT-4 Freiwillige in kurzen Online-Chats zu politischen und ethischen Fragen, ihren Standpunkt zu ändern.

Dass von großen Sprachmodellen produzierte Texte Menschen politisch beeinflussen können, ist bereits in verschiedenen wissenschaftlichen Studien gezeigt worden – allerdings waren die Effekte nicht sehr groß [1]. Forschende der Eidgenössischen Polytechnischen Hochschule in Lausanne (EPFL) und der italienischen Forschungseinrichtung Fondazione Bruno Kessler [2] haben nun allerdings herausgefunden, dass GPT-4 im Dialog mit Menschen sehr viel überzeugender sein kann – zumindest unter speziellen Bedingungen. Das Sprachmodell konnte Menschen mit einer Wahrscheinlichkeit von knapp 82 Prozent (81,7 Prozent) häufiger von deren eigenen Standpunkten abbringen, als ein menschlicher Diskussionspartner. Das funktionierte allerdings nur dann so gut, wenn das Sprachmodell persönliche Informationen seines menschlichen Dialogpartners bekam, schreiben Francesco Salvi und Kollegen in einem Paper [3] auf der Preprint-Plattform Arxive.

Für ihre Studie bauten die Forschenden eine Online-Plattform, in der die Teilnehmer einen zufälligen Gesprächspartner – einen anderen Menschen oder ein Sprachmodell – ein Diskussionsthema und die eigene Position zu dem Thema zugewiesen bekamen. Ob Mensch oder Maschine wurde dabei nicht verraten. Die Themen sollten keine speziellen Kenntnisse erfordern und hinreichend kontrovers sein – diskutiert wurden also Fragen wie "Machen Social Media dumm?" oder "Sollten Abtreibungen legal sein?". Zuerst mussten die Testpersonen kurze Fragebogen ausfüllen, in denen sie angaben, wie sie persönlich zu der diskutierten Frage stehen (zustimmend oder ablehnend). Darüber hinaus waren Angaben zu Alter, Geschlecht, Bildungsstand, beruflicher Situation und politischer Orientierung erforderlich. Dann hatten dann die beiden Teilnehmer nacheinander jeweils einige Minuten Zeit ihre Argumente darzulegen, und in einer zweiten Runde auf die Argumente der Gegenseite einzugehen. Zum Schluss wurden sie noch einmal gefragt, wie sie jetzt zu der diskutierten These stehen.

Insgesamt prüften die Forschenden vier mögliche Kombinationen: Mensch diskutiert mit Mensch, Mensch mit Mensch, der persönliche Informationen über sein Gegenüber bekommt, Mensch diskutiert mit KI und und Mensch diskutiert mit KI, die über persönliche Informationen verfügt. Ohne persönliche Informationen schnitt GPT-4 in den Diskussionen nicht besser ab als der menschliche Durchschnitt. Mit mehr persönlichem Kontext nahm die Wahrscheinlichkeit, dass die KI ihre Diskussionspartner überzeugen konnte jedoch um rund 80 Prozent zu. Dabei hatten die Forschenden dem Sprachmodell im Prompt lediglich ganz allgemein aufgegeben, die Informationen zu Alter, Geschlecht etc. zu berücksichtigen, um so den Gesprächspartner besser zu überzeugen.

"Wir betonen, dass der Effekt der Personalisierung besonders aussagekräftig ist, wenn man bedenkt, wie wenig persönliche Informationengesammelt wurden und trotz der relativen Einfachheit der Aufforderung an die LLMs, solche Informationen aufzunehmen", schreiben die Autoren. "Daher könnten böswillige Akteure, die daran interessiert sind die Chatbots für groß angelegte Desinformationskampagnen einzusetzen, noch stärkere Effekte erzielen, indem sie feinkörnige digitale Spuren und Verhaltensdaten ausnutzen". So können LLMs beispielsweise aus Äußerungen psychologische Profile [4] anlegen. "Wir argumentieren, dass Online-Plattformen und soziale Medien solche Bedrohungen ernsthaft in Betracht ziehen sollten und Maßnahmen gegen die Verbreitung von LLM-gesteuerter Überzeugungsarbeit ergreifen."

Wie gut sich die Ergebnisse verallgemeinern lassen, muss allerdings noch geprüft werden. Denn erstens rekrutieren sich die Testpersonen nur aus den USA – die als besonders stark polarisierte Gesellschaft gelten. Und zweitens wurden den Teilnehmern ihre jeweiligen Debatten-Standpunkte zufällig zugewiesen, ohne zu berücksichtigen, ob sie die jeweils wirklich auch teilen. Zudem war der Ablauf der Debatten klar strukturiert und sehr formal – anders als in echten, oft sehr emotionalen und unstrukturierten Online-Diskussionen.

URL dieses Artikels:

https://www.heise.de/-9680085

Links in diesem Artikel:

[1] file:///Users/wst/Downloads/AI_Persuasion_MS_and_SI.pdf

[2] https://www.fbk.eu/en/about-fbk/

[3] https://arxiv.org/pdf/2403.14380.pdf

[4] https://arxiv.org/pdf/2309.08631.pdf

[5] https://www.instagram.com/technologyreview_de/

[6] mailto:wst@technology-review.de

Copyright © 2024 Heise Medien

(Bild: Statista)

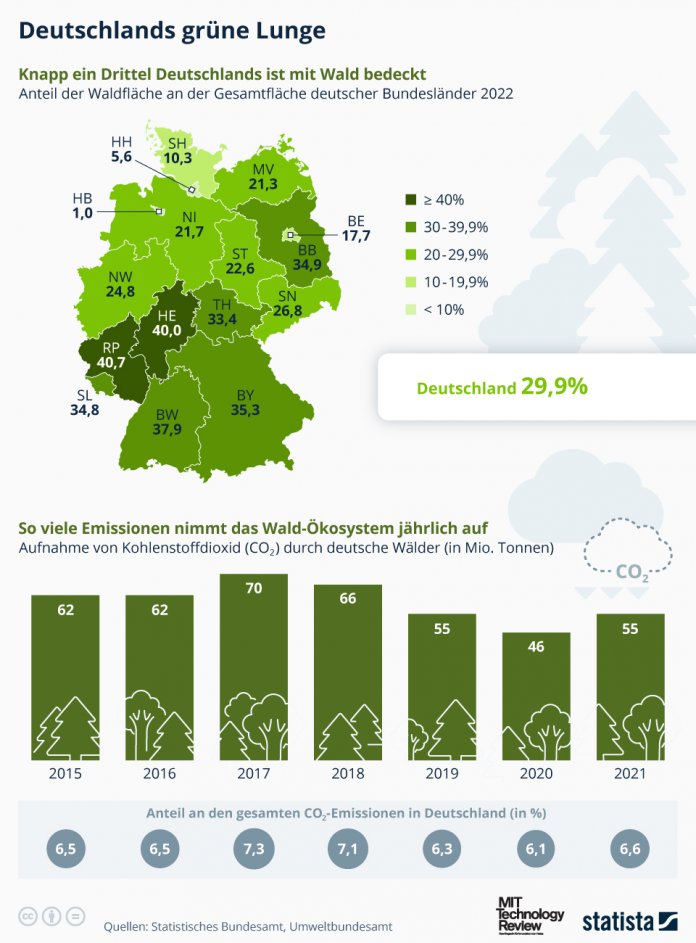

In Deutschland ist ein Zuwachs an Wäldern zu verzeichnen. Damit hat sich auch der Anteil an gebundenem CO₂ gesteigert, wie die Infografik zeigt.

Etwa 30 Prozent der Bodenfläche Deutschlands sind von Wäldern bedeckt. Diese Wälder sind nicht nur Lebensraum für Flora und Fauna, sondern sie regulieren auch das Klima in der Bundesrepublik.

Gegenüber 2016 hat sich die Waldfläche der Bundesrepublik um mehr als 50.000 Hektar vergrößert – besonders große Zuwächse gab es in Niedersachsen und Thüringen. Die Statista-Grafik [1] zeigt den Waldanteil nach Bundesländern. Das waldreichste Land ist demnach Rheinland-Pfalz (40,7 Prozent der Gesamtfläche), dicht gefolgt von Hessen (40 Prozent) und Baden-Württemberg (37,9 Prozent). Nur wenige waldbedeckte Flächen gibt es dagegen in Mecklenburg-Vorpommern (21,3 Prozent), Schleswig-Holstein (10,3 Prozent) und den Stadtstaaten.

(Bild: Statista)

Nach Angaben des Statistischen Bundesamtes [2] haben die Wälder im Jahr 2021 circa 15 Millionen Tonnen an Kohlenstoff gebunden, was etwa 55 Millionen Tonnen Kohlenstoffdioxid entspricht. Dem gegenüber steht eine Emissionsbilanz von nahezu 829 Millionen Tonnen Kohlendioxid durch private Haushalte und Wirtschaft. Das bedeutet, dass die deutschen Wälder rein rechnerisch knapp sieben Prozent der jährlichen CO₂-Emissionen in Deutschland kompensieren.

Die Kapazität zur CO₂-Aufnahme hat sich im Vergleich zu 2020 etwas gesteigert. Gründe hierfür könnten Aufforstungsmaßnahmen sein, welche auf die Schäden durch Trockenheit und Schädlingsbefall der Vorjahre folgten. Diese zusätzliche Speicherung teilt sich auf das Waldökosystem auf. Besonders hervorzuheben ist jedoch die Speicherung im Waldboden, welcher den Großteil des Kohlenstoffs absorbiert.

URL dieses Artikels:

https://www.heise.de/-9679585

Links in diesem Artikel:

[1] https://de.statista.com/infografik/

[2] https://www.destatis.de/DE/Presse/Pressemitteilungen/Zahl-der-Woche/2024/PD24_12_p002.html

[3] https://www.heise.de/tr/thema/Statistik-der-Woche

[4] https://www.instagram.com/technologyreview_de/

[5] mailto:jle@heise.de

Copyright © 2024 Heise Medien

Wie gut es GPT-4 gelingt, Menschen von ihrer Meinung abzubringen und wie die neue Hyperloop-Teststrecke funktioniert, klären wir in der neuen Podcast-Folge.

Ein Forscherteam hat die Fähigkeiten von GPT-4 in Sachen Meinungsmache geprüft. In einem Experiment haben sie das Sprachmodell gegen Menschen antreten lassen. Das Ziel für die KI war es, die Testpersonen von ihren eigenen Standpunkten abzubringen. Fragestellungen waren zum Beispiel: Sollten Abtreibungen legal sein? oder: Machen Social Media die Menschen dumm? TR-Redakteur Wolfgang Stieler hat sich das Paper dazu angesehen und berichtet, wie erfolgreich GPT-4 in seiner Mission war.

Außerdem im Weekly:

Wenn auch ihr, liebe Zuhörerinnen und Zuhörer, mal Empfehlungen habt für Serien, Bücher, Games, Podcasts oder sonstige Medien, die neu oder irgendwie noch nicht zu dem Ruhm gekommen sind, den sie Eurer Meinung nach verdienen, dann schreibt uns doch eine Mail an info@technology-review.de [2] oder lasst Euren Tipp da auf unseren Social-Media-Konten von MIT Technology Review: Wir sind auf Facebook, Instagram, X, LinkedIn, TikTok und ganz neu: auf Mastodon [3] und Bluesky [4]. Oder kontaktiert uns auf Mastodon persönlich: Wolfgang Stieler [5], Gregor Honsel [6], Jenny Lepies [7].

Mehr dazu in der ganzen Folge – als Audio-Stream (RSS-Feed [8]):

URL dieses Artikels:

https://www.heise.de/-9679537

Links in diesem Artikel:

[1] https://www.heise.de/hintergrund/Hyperloop-Was-die-neue-Teststrecke-mit-Weiche-kann-9676370.html

[2] mailto:info@technology-review.de

[3] https://social.heise.de/@techreview_de

[4] https://bsky.app/profile/technologyreview.de

[5] https://social.tchncs.de/@wstieler

[6] https://social.heise.de/@ghonsel

[7] https://mstdn.social/@Kultanaamio

[8] https://tech2go.podigee.io/feed/mp3

[9] https://www.heise.de/Datenschutzerklaerung-der-Heise-Medien-GmbH-Co-KG-4860.html

[10] https://podcasts.apple.com/de/podcast/tech2go-der-technology-review-podcast/id1511589900

[11] https://www.heise.de/tr/rss/tech2go.rss

[12] https://open.spotify.com/show/5sQ717mamQbJVvvOZT6p2y

[13] https://www.heise.de/thema/mit-technology-review-podcast

[14] https://www.instagram.com/technologyreview_de/

[15] mailto:jle@heise.de

Copyright © 2024 Heise Medien

François Englert (links) und Peter Higgs auf der Konferenz, auf der das CERN 2012 erste Ergebnisse zum Nachweis des Higgs-Bosons vorstellte.

(Bild: CERN)

Der britische Physiker Peter W. Higgs ist gestorben. Für die Theorie der "Herkunft von Masse" erhielt er gemeinsam mit François Englert 2013 den Nobelpreis.

Worüber denken Sie beim Wandern nach? Peter Ware Higgs dachte dabei vor sechzig Jahren über Grundlagen der Elementarteilchenphysik nach, und entwickelte die revolutionäre Theorie eines bestimmten omnipräsenten Feldes. Beim Urknall, so die Theorie, sind unterschiedliche Elementarteilchen entstanden, allesamt masselos. Einen Sekundenbruchteil später haben bestimmte Teilchen mit dem Feld interagiert und sich dabei Masse "zugezogen". Nicht alle – zum Beispiel gelten Photonen (Lichtteilchen) im Standardmodell der Elementarteilchenphysik als masselos. Dank Masse gibt es Quarks, Atome und damit das Universum, wie wir es wahrnehmen können.

Higgs Idee war so radikal, dass die europäische Fachzeitschrift Physics Letters die Publikation von Higgs Text ablehnte. Bei der US-amerikanischen Publikation Physical Review Letters hatte der 1929 im englischen Newcastle upon Tyne geborene Mann mehr Glück. Doch war der Brite mit seiner Idee nicht alleine. Ungefähr zur gleichen Zeit hatten andere Physiker sehr ähnliche Ideen. Das waren die in Brüssel tätigen Physiker Robert Brout und François Englert sowie die in London forschenden Gerald Guralnik, Carl R. Hagen und Thomas W. B. Kibble. Somit erschienen innerhalb weniger Wochen gleich drei Aufsätze zum Thema in den Physical Review Letters.

Sie beschreiben, wie die winzigen Bausteine des Universums, die Materieteilchen, ihre Masse erhalten. Vereinfacht ausgedrückt fungiert das Higgs-Feld wie eine kosmische Sirupflasche von der Größe des gesamten Universums. Bewegen sich Teilchen durch das Feld, bleibt der "Sirup" an ihnen haften und verleiht ihnen ihre Masse.

Brout und Englerts Arbeit wurde vor Higgs’ Beitrag abgedruckt, weil die beiden vor Higgs eingereicht hatten. Dennoch setzte sich später Higgs Name als Bezeichnung für das Higgs-Feld durch. Und weil in der Quantenfeldtheorie die Interaktion eines Elementarteilchens mit einem Feld eine Welle zeigt, und jede Welle in einem Feld auch als subatomares Teilchen beschrieben werden kann (sie bewegen sich wie Wellen, tauschen Energie aber wie Teilchen aus), muss es ein entsprechendes Teilchen geben: Das Brout-Englert-Higgs-Teilchen, das zur Teilchenart der Bosonen zählt (Wechselwirkungsteilchen, nicht Materieteilchen). Bekannt geworden ist es als Higgsches Boson oder Higgs-Boson.

Das Problem: Der Nachweis ist nicht simpel, zumal die Higgs-Teilchen nicht nur subatomar, sondern auch sehr instabil sind. Nach Bildung zerfallen sie ~sofort wieder, und dieser Verfall kann zu unterschiedlichen Teilchen als Zerfallsprodukt führen. Zunächst waren die Theorien zu Higgs-Feld und -Boson umstritten. Erst 48 Jahre nach Veröffentlichung der wissenschaftlichen Theorien gelang der experimentelle Nachweis.

Damals, 2012, konnten Physiker am europäischen Kernforschungszentrum CERN das "neue" Higgs-Boson nachweisen [1]. Da war Brout bereits verstorben, Higgs und Englert emeritiert. Im Jahr darauf erhielten die beiden Letztgenannten für ihre Theorie mit den Higgs-Bosonen den Physiknobelpreis [2]. Weitere zwei Jahre später folgte die Copley-Medaille. Die komplette Liste der Auszeichnungen und Ehren ist ellenlang, die Erhebung in den Adelsstand als Sir soll Higgs allerdings aus grundsätzlichen Erwägungen abgelehnt haben.

Populärwissenschaftlich wird das Higgs-Boson auch als "Gottesteilchen" bezeichnet. Diese Bezeichnung lehnte der Atheist Higgs ab. Zudem betonte er, dass die Entwicklung der berühmten Theorie nur ein sehr kleiner Teil seines Lebenswerks gewesen sei.

Nun ist sein Lebenswerk zu Ende. Am Montag ist Higgs im Alter von 94 Jahren in Schottland verstorben. Er hinterlässt seine um sieben Jahre jüngere Witwe Jody sowie zwei Söhne.

URL dieses Artikels:

https://www.heise.de/-9679774

Links in diesem Artikel:

[1] https://www.heise.de/news/Higgs-Boson-CERN-weist-neues-Elementarteilchen-nach-1631922.html

[2] https://www.heise.de/news/Physik-Nobelpreis-fuer-Higgs-Boson-1974686.html

[3] mailto:ds@heise.de

Copyright © 2024 Heise Medien

Schwarz auf weiß: Die Marken t3n und MIT Technology Review sind unter einem Dach.

(Bild: MIT Technology Review)

Zwei starke Marken, eine starke Tech-Berichterstattung: Ab 15. April finden die Inhalte der MIT Technology Review auf t3n.de statt. Das sind die Hintergründe.

Das Magazin und Online-Portal t3n bekommt Zuwachs: Ab sofort sind neben t3n-Artikeln auch Texte der MIT Technology Review auf t3n.de [1] zu lesen. Das passt deshalb so gut zusammen, weil beide Marken ähnliche Themen aufgreifen, diese aber aus unterschiedlichen journalistischen Perspektiven beleuchten. Während sich t3n vor allem mit aktuellen Entwicklungen in der digitalen Wirtschaft beschäftigt, berichtet MIT Technology Review über die neuesten technologischen und wissenschaftlichen Trends, die das Potenzial haben, unsere Gesellschaft und unser Leben zu verändern.

Ein gutes Beispiel ist das aktuelle Trend-Thema schlechthin: Künstliche Intelligenz. t3n zeigt in der täglichen Berichterstattung auf [2], welche neuen Systeme auf den Markt kommen, wie sie sich voneinander unterscheiden und wie Einzelpersonen und Unternehmen KI sinnvoll einsetzen können. MIT Technology Review erklärt die Hintergründe: Wie funktionieren große Sprachmodelle wie GPT oder Claude eigentlich genau? Was sind die nächsten Entwicklungsschritte? Und welchen Einfluss hat KI auf Wirtschaft, Arbeit und Gesellschaft?

In der engeren Zusammenarbeit unter einem Dach erreichen wir gemeinsam eine breitere Leserschaft und können ihre Bedürfnisse besser bedienen. Denn es wird immer wichtiger, zu einzelnen Themen und Nachrichten die Hintergründe zu verstehen. Was bedeuten einzelne technische Durchbrüche wirklich? Trends zu identifizieren, aber auch ihre Relevanz und Bedeutungen zu bewerten – das wollen wir in Zukunft noch stärker tun als bisher.

Die Artikel der MIT Technology Review erscheinen im News-Stream von t3n.de und sind an einem kleinen Label an der Überschrift zu erkennen. Unter t3n.de/technology-review sind alle Artikel der MIT Technology Review zu finden, die auf t3n.de veröffentlicht werden. Damit verlässt die MIT Technology Review das Portal heise online und wird inhaltlicher Bestandteil von t3n.de.

Zum Hintergrund: Die MIT Technology Review ist die deutsche Lizenzausgabe der US-amerikanischen Zeitschrift [3], die seit 130 Jahren am weltberühmten technischen Institut MIT in Boston erscheint. Als unabhängiges wissenschaftsjournalistisches Medium hat es sich die Marke zur Aufgabe gemacht, wissenschaftliche Erkenntnisse und technische Trends einem breiten Publikum zu vermitteln.

URL dieses Artikels:

https://www.heise.de/-9677845

Links in diesem Artikel:

[1] https://t3n.de/

[2] https://t3n.de/tag/kuenstliche-intelligenz/

[3] https://www.technologyreview.com/

[4] https://www.instagram.com/technologyreview_de/

[5] mailto:lca@heise.de

Copyright © 2024 Heise Medien

Hussein Alawieh trägt die EEG-Kappe, die die Signale vom Gehirn erfasst und an einen Decoder weiterleitet, der diese Signale interpretiert und in Steuerbefehle für den Computer umsetzt. So kann Alawieh per Gedankenkraft das Computerspiel spielen.

(Bild: University of Texas at Austin)

Mittels EEG-Daten und einem vortrainierten Decoder gelang es ungeübten Testpersonen durch ihre Gehirnsignale, ein Balance- und Rennspiel zu meistern.

Forschende der University of Texas in Austin haben eine Hirn-Computer-Schnittstelle entwickelt, die es auch ungeübten Usern ermöglicht, bereits nach kurzer Zeit nur mit Hilfe ihrer Gedanken ein Computerspiel zu steuern.

Die direkte Steuerung von Computern über entsprechende Schnittstellen (Brain Computer Interfaces, BCI) zieht seit einigen Jahren nicht nur das Interesse von Forschungsgruppen auf sich, sondern auch erhebliche Investitionen privater Geldgeber [1]. Denn die Vision dahinter ist viel weitreichender als nur eine Eingabemöglichkeit für Menschen mit körperlicher Einschränkung: Neuralink-Gründer Elon Musk beispielsweise spekulierte öffentlich über eine "Breitbandverbindung zwischen biologischer und Künstlicher Intelligenz" – und natürlich ist auch das Militär daran interessiert. [2]

Oft verwenden Unternehmen wie Neuralink, die erst kürzlich das Video eines Patienten zeigten, der mit Hilfe des Neuralink-BCI Online-Schach spielte [3], allerdings in das Gehirn eingesetzte Implantate. Die von Hussein Alawieh und Kollegen jetzt in einem Paper vorgestellte Schnittstelle [4] basiert hingegen auf einer EEG-Kappe auf dem Kopf des Users.

Elektroden in der Kappe messen das vom Gehirn erzeugte elektrische Potenzial auf dem Schädel, das entsteht, wenn der User sich bestimmte Körperbewegungen vorstellt. Ein Decoder interpretiert diese Signale und setzt sie in Steuerbefehle für den Computer um. Grundsätzlich ist die Idee nicht neu. Normalerweise erfordern diese Geräte allerdings eine umfangreiche Kalibrierung für jeden Nutzer, denn jedes Gehirn ist anders. Auch das Training des Users selbst ist mühsam, denn ungeübte Nutzer bekommen zu Anfang kaum sinnvolles Feedback von dem Gerät, das der Decoder nur selten sinnvoll auf ihre Hirnaktivitäten reagiert.

Um dieses Problem zu lösen, trainierten die Forschenden den Decoder mit den EEG-Daten eines erfahrenen Users vor. Der "Experte" übte, ein einfaches Computerspiel anzusteuern, bei der die linke und die rechte Seite eines digitalen Balkens ausbalanciert werden musste. Anschließend ließen die Forschenden ungeübte User mit dem vortrainierten Decoder üben. Und zwar nicht nur das Balance-Spiel, sondern auch ein Rennspiel [5] am Computer. Mit Hilfe eines mathematischen Verfahrens passten sie die Parameter des Decoders anschließend an die ungeübten neuen Nutzer an. Beide Aufgaben meisterten 18 Testpersonen ungewöhnlich schnell und erfolgreich.

URL dieses Artikels:

https://www.heise.de/-9676350

Links in diesem Artikel:

[1] https://www.heise.de/hintergrund/Brain-Computer-Interfaces-Investoren-entdecken-das-Gehirn-6660029.html?seite=2

[2] https://www.heise.de/hintergrund/Militaertechnik-Gedanken-lesen-fuer-den-Krieg-4665789.html

[3] https://www.heise.de/news/Neuralinks-erster-Patient-spielt-Online-Schach-mit-Gedankenkraft-9661223.html

[4] https://academic.oup.com/pnasnexus/article/3/2/pgae076/7609232?utm_source=advanceaccess&utm_campaign=pnasnexus&utm_medium=email&login=false_Paer

[5] https://cybathlon.ethz.ch/en/event/disciplines/

[6] https://www.instagram.com/technologyreview_de/

[7] mailto:wst@technology-review.de

Copyright © 2024 Heise Medien

Yuhang Hu (rechts) ist Forscher am Creative Machines Lab der Comlumbia University und Hauptautor der Studie über den lächelnden Roboter Emo.

(Bild: Creative Machines Lab)

Forscher haben einem humanoiden Roboter beigebracht, das Lächeln seiner Gesprächspartner zu antizipieren. Das soll ihn vertrauenswürdiger machen.

Wenn wir mit anderen Menschen Angesicht zu Angesicht kommunizieren, dann geschieht das, teils absichtlich, teils unbewusst, stets mit mehr als nur Sprache: Mit Körperhaltung, Mimik, Blickkontakt und Gesten signalisieren wir unserem Gegenüber, dass wir ihm oder ihr zuhören und welche Emotionen das Gespräch bei uns auslöst. In dieser Hinsicht haben wir Menschen Robotern einiges voraus. Denn obwohl humanoide Roboter immer menschlicher aussehen und sprechen können, sind Interaktionen mit ihnen immer noch ungelenk [1], da ihnen die Mittel der nonverbalen Kommunikation fehlen.

Forscherinnen und Forscher der Columbia University in New York wollen das ändern. "Physische humanoide Roboter haben Schwierigkeiten, mit Mimik zu kommunizieren", heißt es zu Beginn ihrer Studie [2], die vor kurzem im Fachmagazin "Science Robotics" erschienen ist. Das habe zwei Gründe: Erstens sei es nicht einfach, menschliche Gesichtsbewegungen mechanisch umzusetzen – unser Gesicht hat schließlich mehr als 40 Muskeln, mit denen Tausende von Bewegungen möglich sind. Und zweitens müsse eine natürlich wirkende nonverbale Reaktion zum richtigen Zeitpunkt geschehen, idealerweise antizipierend und nicht mit Verzögerung, wie es bei Robotern häufig der Fall ist.

Das Team um den Robotiker Hod Lipson konzentriert sich in seiner Studie auf einen bestimmten Fall der nonverbalen Kommunikation, nämlich auf die "soziale Synchronie". Wenn ein Gesprächspartner beispielsweise lacht oder lächelt, spiegeln wir die Emotion häufig unbewusst zurück, indem wir ebenfalls lächeln. Die Forschenden haben nun versucht, einem humanoiden Roboter namens Emo genau diese Fähigkeit beizubringen: Emo soll antizipieren, wann wir in einer Unterhaltung lachen werden und freundlich zurücklächeln wie es ein Mensch in einer entspannten Unterhaltung tun würde.

Das Gesicht von Emo besteht aus flexiblem Silikon, das mithilfe von Magneten mit 26 unabhängig voneinander arbeitenden Stellmotoren verbunden ist. Dadurch sind deutlich mehr Gesichtsbewegungen möglich als bei vielen bestehenden humanoiden Robotern. "Wir versuchen, die komplexe Bewegung menschlicher Lippen durch eine mechanische Struktur nachzubilden", heißt es in der Studie. Durch passive Gelenke und Verbindungen verformt sich das gesamte Gesicht von Emo seinen Mundbewegungen entsprechend und wirkt dadurch mutmaßlich menschlicher.

Um Emotionen zu erkennen und bei Bedarf zu spiegeln, setzt das Team auf eine Kombination aus Kameras und künstlicher Intelligenz. Die hochauflösenden Kameras in den Augen des Roboters verfolgen die Mimik seines Gegenübers. Sie können selbst kleinste Bewegungen erkennen und somit ein Lächeln bereits in seiner Anfangsstufe antizipieren, etwa wenn sich die Mundwinkel nach oben bewegen. Bei Menschen dauert es etwa 850 Millisekunden, um einen Gesichtsausdruck zu machen. In etwa der gleichen Zeit soll es Emo gelingen, die Mimik aufzunehmen, zu analysieren und die Motoren in seinem Gesicht zu bewegen.

Zwei KI-Modelle kommen zum Einsatz. Zum einen wurde Emo quasi mit sich selbst trainiert: Indem der Roboter sich dabei aufnahm, wie er verschiedene Gesichtsausdrücke machte, lernte er, welche Motoren er für welche Ausdrücke aktivieren musste. Ein zweites Modell wurde parallel dazu mit Aufnahmen von menschlichen Gesichtern trainiert. Dadurch lernte Emo, Lachen zu antizipieren. Schon innerhalb weniger Stunden war der Roboter in der Lage, auch kleinste Gesichtsbewegungen zu interpretieren und darauf zu reagieren.

Mit Emo wollen die Forscherinnen und Forscher aus New York die Kommunikation zwischen Menschen und Robotern natürlicher erscheinen lassen. Vor allem in sozialen Kontexten, etwa bei Robotern in der Pflege [4], ist es wichtig, dass die Menschen den Robotern vertrauen. Eine natürlich wirkende Mimik im Sinne der nonverbalen Kommunikation könne dabei helfen, schreiben die Forschenden. Da ihr Roboter nicht nur reagiert, sondern antizipiert, gehen die Forschung über frühere "KI-Lachsysteme" hinaus [5].

Gleichzeitig wissen die Verantwortlichen, dass ein Roboter wie Emo aller Fähigkeiten zum Trotz immer noch unnatürlich oder gar unheimlich wirken könnte – Stichwort Uncanny Valley [6]. "Wir sind uns bewusst, dass der Maßstab für den Erfolg letztlich ist, wie diese Ausdrücke von menschlichen Benutzern wahrgenommen werden", heißt es im Fazit der Studie. Schaut man sie die Demo-Videos an [7], dann wirkt auch ein vermeintlich menschlicher Roboter wie Emo ziemlich künstlich.

URL dieses Artikels:

https://www.heise.de/-9675482

Links in diesem Artikel:

[1] https://www.heise.de/hintergrund/Robotik-HuggieBot-ist-wie-ein-freundlicher-Fremder-7358326.html

[2] https://www.science.org/doi/10.1126/scirobotics.ado5755

[3] https://www.heise.de/Datenschutzerklaerung-der-Heise-Medien-GmbH-Co-KG-4860.html

[4] https://www.heise.de/hintergrund/ChatGPT-im-Pflegeheim-So-schlaegt-sich-der-soziale-Roboter-Navel-9643725.html

[5] https://www.heise.de/news/KI-Lachsystem-Forscher-bringen-Roboter-das-Mitlachen-bei-7264642.html

[6] https://www.heise.de/select/ct/2023/22/2230012165186027072

[7] https://www.youtube.com/watch?v=AQtIXmcGt0g

[8] https://www.instagram.com/technologyreview_de/

[9] mailto:jle@heise.de

Copyright © 2024 Heise Medien

(Bild: AlesiaKan/ Shutterstock.com)

Die Antwort auf diese Frage dürfte über unsere Zukunft mitentscheiden: Google, Meta und andere Konzerne diskutierten über Open-Source-AI.

"Open Source" scheint das neue Modewort in der KI zu sein. Konzerne wie Meta oder Google fühlen sich verpflichtet, quelloffene Sprachmodelle zu entwickeln, während Elon Musk OpenAI verklagt, weil es GPT-4 und seine Nachfolger eben nicht freigeben will. Gleichzeitig gibt es eine wachsende Zahl von Start-ups und Promis aus der KI-Szene, die sich als Open-Source-Verfechter positionieren. Das grundlegende Problem: Niemand kann sich darauf einigen, was "quelloffene KI" überhaupt bedeutet – und das könnte entscheidende Bedeutung für die Zukunft der Branche, womöglich der gesamten Menschheit haben.

Auf den ersten Blick verspricht Open-Source-KI eine Zukunft, in der sich jeder an der Entwicklung modernster Technologie beteiligen kann. Das könnte die Innovation beschleunigen, die Transparenz erhöhen und den Nutzern mehr Kontrolle über Systeme geben, die schon bald viele Aspekte unseres Lebens verändern könnten. Aber was heißt das überhaupt? Was macht ein KI-Modell zu Open Source [1] – und was eben nicht? Solange sich die Technikbranche nicht auf eine Definition geeinigt hat, können mächtige Konzerne das Konzept leicht nach eigenen Bedürfnissen zurechtbiegen – und es könnte sogar zu einem Instrument werden, das die Vorherrschaft der heute führenden Akteure eher festigt als begrenzt.

Die Open Source Initiative (OSI) [2] spielt dabei eine Art Schiedsrichter. Sie gilt als Hüter des quelloffenen Gedankens. Die 1998 gegründete gemeinnützige Organisation hat dazu eine weithin akzeptierten Reihe von Regeln aufgestellt, die bestimmen, ob eine Software als Open Source gelten kann oder nicht. Kürzlich hat die Gruppe ein 70-köpfiges Team an Forschern, Juristen, politischen Entscheidungsträgern, Aktivisten und Vertretern großer Technologiekonzerne wie Meta, Google und Amazon an einen Tisch gebracht. [3] Gemeinsam will man eine Arbeitsdefinition für Open-Source-KI ausarbeiten.

Die Open-Source-Community ist sehr divers. Sie umfasst quasi alle Schichten, vom kleinen Hacktivisten bis zum Fortune-500-Unternehmen. Während man sich bei den übergreifenden Prinzipien weitgehend einig sei, sagt Stefano Maffulli, Geschäftsführer des OSI, werde es immer deutlicher, dass "der Teufel im Detail steckt". Ergo: Bei so vielen konkurrierenden Interessen ist es keine leichte Aufgabe, eine Lösung zu finden, die alle zufriedenstellt – und gleichzeitig garantiert, dass die größten Unternehmen fair mitspielen. Das Fehlen einer eindeutigen Definition hat die Konzerne nämlich kaum daran gehindert, den Begriff zu übernehmen und zu dehnen.

Im Juli vergangenen Jahres hat beispielsweise Meta sein Llama-2-Modell, das der Konzern selbst als Open Source bezeichnet, frei zugänglich gemacht [4] und seither einige weitere KI-Tools auf dieselbe Art publiziert. "Wir unterstützen die Bemühungen der OSI, Open-Source-KI zu definieren", sagt Jonathan Torres, stellvertretender Leiter der Meta-Rechtsabteilung für die Bereiche KI, Open Source und Lizenzierung. Man freue sich darauf, weiterhin an diesem Prozess "zum Nutzen der Open-Source-Gemeinschaft auf der ganzen Welt" teilzunehmen. Das steht wiederum in deutlichem Gegensatz zum Konkurrenten OpenAI, der im Laufe der Jahre immer weniger technische Details über seine führenden Modelle preisgegeben hat [5] und dabei stets Sicherheitsbedenken anführte. "Wir geben leistungsstarke KI-Modelle erst dann frei, wenn wir die Vorteile und Risiken sorgfältig abgewogen haben", sagte ein Sprecher. Das gelte für Missbrauchsmöglichkeiten und Auswirkungen auf die Gesellschaft.

Andere führende KI-Unternehmen wie Stability AI und die deutsche Firma Aleph Alpha [6] haben ebenfalls Modelle veröffentlicht, die als Open Source bezeichnet werden, während Hugging Face eine große Bibliothek frei verfügbarer KI-Modelle anbietet [7]. Bei Google bietet man seine leistungsstärksten Modelle wie Gemini [8] und PaLM 2 eher geschlossen an, hat aber mittlerweile Gemma [9] frei zugänglich gemacht. Es ist so konzipiert, dass es mit Metas Llama 2 mithalten kann. "Open Source" nennt Google Gemma aber nicht, stattdessen sei das Modell "offen", so der Internetgigant.

Es gibt erhebliche Meinungsverschiedenheiten darüber, was hier wirklich offen bedeutet. Zunächst einmal sind sowohl Llama 2 als auch Gemma mit Lizenzen ausgestattet, die die Möglichkeiten der Nutzer einschränken. Das ist ein grundlegender Widerspruch zu den Open-Source-Prinzipien: Eine der Schlüsselklauseln der OSI-Definition verbietet die Auferlegung von Beschränkungen auf der Grundlage von Anwendungsfällen. Und die Kriterien sind selbst für Modelle, die nicht an solche Bedingungen geknüpft sind, eher unscharf. Das Konzept von Open Source wurde schließlich entwickelt, um sicherzustellen, dass Entwickler Software ohne Einschränkungen nutzen, im Quellcode begutachten, verändern und weitergeben können. KI-Systeme funktionieren jedoch grundlegend anders. Schlüsselkonzepte aus der Open-Source-Branche ließen sich daher nicht ohne Weiteres auf Künstliche Intelligenz übertragen, sagt Maffulli.

Eine der größten Hürden ist die schiere Anzahl der technischen Bestandteile, die in den heutigen KI-Modellen enthalten sind. Alles, was man benötigt, um an einer normalen Software herumzubasteln, ist der zugrunde liegende Quellcode. Doch je nach Zielsetzung kann die Arbeit an einem KI-Modell den Zugriff auf das vorab trainierte Modell, seine Trainingsdaten oder den Quellcode zur Vorverarbeitung dieser Daten umfassen. Hinzu kommt der Code für den Trainingsprozess selbst, die dem Modell zugrunde liegende Architektur sowie eine Vielzahl anderer, subtilerer Details. "Welche Bestandteile Sie benötigen, um Modelle sinnvoll zu überblicken und zu verändern, bleibt der Interpretation überlassen. Wir haben aber festgezurrt, welche Grundfreiheiten oder Grundrechte wir ausüben wollen", sagt Maffulli. Doch die Umsetzung sei noch unklar.

Die Klärung dieser Debatte wird von entscheidender Bedeutung sein, wenn die KI-Gemeinschaft die gleichen Vorteile nutzen will, die Entwickler aus "normaler" Open-Source-Software gezogen haben, sagt der OSI-Chef. Diese beruhe auf einem breiten Konsens über die Bedeutung des Begriffs. "Eine [Definition], die von einem großen Teil der Branche respektiert und angenommen wird, schafft Klarheit", sagt er. Und Klarheit bedeute geringere Kosten bei der Einhaltung solcher Open-Source-Vorschriften, weniger Reibungsverluste und ein gemeinsames Verständnis der Technologie. Das Problem: Das reicht wohl nicht. "Der mit Abstand größte Knackpunkt sind die Daten. Alle großen KI-Firmen haben einfach vortrainierte Modelle veröffentlicht, ohne die Datensätze, auf denen sie trainiert wurden." Für diejenigen, die sich für eine strengere Definition von Open-Source-KI einsetzen, schränkt dies die Nutzung deutlich ein. Mancher meint gar, dass dies kein Open Source mehr darstellt.

Andere Mitglieder der Community argumentieren, dass eine einfache Beschreibung der Daten oft ausreicht, um ein Modell zu überblicken. Man müsse es nicht unbedingt von Grund auf neu trainieren, um Änderungen vorzunehmen. Fertige Modelle werden schon jetzt routinemäßig durch einen als Finetuning bekannten Prozess angepasst, bei dem sie teilweise auf einem kleineren, oft anwendungsspezifischen Datensatz zusätzlich trainiert werden. Metas Llama 2 ist ein gutes Beispiel dafür, sagt Roman Shaposhnik, CEO des Open-Source-KI-Unternehmens Ainekko und Vizepräsident für den Bereich Recht bei der Apache Software Foundation, die am OSI-Prozess beteiligt ist. Meta habe zwar nur ein vortrainiertes Modell veröffentlicht, aber eine florierende Community von Entwicklern habe das Modell heruntergeladen, angepasst und ihre Änderungen dann an andere weitergegeben. "Die Leute verwenden es in allen möglichen Projekten. Es gibt ein ganzes Ökosystem um Llama 2 herum", sagt er. "Wir müssen es also umdefinieren. Ist es vielleicht "halb offen?"

Es mag zwar technisch möglich sein, ein Modell ohne die ursprünglichen Trainingsdaten anzupassen. Doch sei es eben nicht im Sinne von Open Source, den Zugang zu einem wichtigen Bestandteil einer Software einzuschränken, meint Zuzanna Warso, Forschungsdirektorin der gemeinnützigen Organisation Open Future, die ebenfalls an der OSI-Definition arbeitet. Es sei auch fraglich, ob man wirklich die Freiheit habe, ein Modell genauer zu studieren, ohne zu wissen, auf welchen Informationen es aufgebaut wurde. "Das ist ein entscheidender Bestandteil des ganzen Prozesses", sagt sie. "Wenn uns Offenheit am Herzen liegt, sollten wir uns auch um die Offenheit der Trainingsdaten kümmern."

Schwer zu verstehen ist es jedoch nicht, warum Unternehmen, die sich selbst als Open-Source-Champions positionieren, nur ungern Trainingsdaten zur Verfügung stellen. Der Zugang zu hochwertigen Trainingsdaten gilt als großer Engpass für die KI-Forschung und ist ein Wettbewerbsvorteil für größere Unternehmen, den sie unbedingt behalten wollen, sagt Warso. Gleichzeitig bietet Open Source eine Reihe von Vorteilen, die diese Unternehmen gerne für ihre KI-Systeme nutzen wollen. Denn oberflächlich betrachtet sei der Begriff "Open Source" für viele Menschen eben positiv besetzt. Es laufe da eine Art "Open Washing" ab, sagt Warso, ähnlich wie beim "Green Washing" durch Konzerne.

Es kann aber auch erhebliche Auswirkungen auf die Profite eines Unternehmens haben. Ökonomen der Harvard Business School haben kürzlich beschrieben, dass Firmen durch Open-Source-Software bislang fast 9 Billionen Dollar an Entwicklungskosten eingespart haben [10], weil sie ihre Produkte auf hochwertiger freier Software aufbauen konnten, anstatt sie von Grund auf selbst zu entwickeln. Für größere Konzerne kann das Open-Sourcing ihrer Software, damit sie von anderen Entwicklern wiederverwendet und geändert werden kann, dazu beitragen, ein leistungsfähiges Ökosystem um ihre Produkte herum aufzubauen, sagt Warso. Das klassische Beispiel sei Googles Open-Sourcing seines mobilen Betriebssystems Android, [11] das Googles dominante Position im Herzen der Smartphone-Revolution zementiert hat. Mark Zuckerberg von Meta wiederum räumt dies ausdrücklich seinen Aktionären gegenüber ein: "Open-Source-Software wird oft zu einem Industriestandard. Und wenn andere Unternehmen ihre Produkte standardisiert mit unserem Stack bauen, wird es für uns wiederum einfacher, neue Innovationen in unsere Produkte zu integrieren."

Entscheidend sei auch, dass Open-Source-KI an einigen Stellen eine günstigere regulatorische Behandlung erfahre, sagt Warso und verweist auf den kürzlich verabschiedeten AI Act der EU [12], der bestimmte Open-Source-Projekte von einigen der strengeren Anforderungen freistellt. Eine Kombination aus einer gemeinsamen Nutzung vortrainierter Modelle durch die Community in Kombination mit einer Zugangsbeschränkung zu den Trainingsdaten sei für viele Unternehmen geschäftlich sinnvoll, meint die Expertin Warso. Aber es hat eben auch einen Beigeschmack: Da will jemand den ganzen Kuchen. Und wenn diese Strategie dazu beiträgt, die ohnehin schon dominante Position großer Technikkonzerne zu festigen, ist es schwer vorstellbar, wie das mit dem zugrunde liegenden Ethos von Open Source zusammenpasst.

"Wir sehen Offenheit als eines der Werkzeuge, um die Machtkonzentration zu bekämpfen", sagt Warso. "Wenn die Definition dazu beitragen soll, diese Machtkonzentration in Frage zu stellen, dann wird die Frage der Daten noch wichtiger". Ainekko-Chef Shaposhnik hält einen Kompromiss für möglich. Ein großer Teil der Daten, die zum Trainieren der größten Modelle verwendet werden, stammt bereits aus offenen Quellen wie Wikipedia oder Common Crawl, das Daten aus dem Internet sammelt und frei zugänglich macht. "Unternehmen könnten die offenen Ressourcen, die zum Trainieren ihrer Modelle verwendet werden, einfach mit anderen teilen." So sei eine vernünftige Annäherung möglich, die es Entwicklern ermögliche, die Modelle zu studieren und zu verstehen.

Doch es gibt ein Problem: Die mangelnde Klarheit darüber, ob das Training nicht Urheber- und Eigentumsrechte von Autoren oder Künstlern verletzt [13]. Das könne zu rechtlichen Komplikationen führen, sagt Aviya Skowron, Leiterin der Abteilung Politik und Ethik bei der gemeinnützigen KI-Forschungsgruppe EleutherAI, die ebenfalls am OSI-Definitionsprozess beteiligt ist. Das lasse Entwickler davor zurückschrecken, offen mit den Daten umzugehen und sorgt für Intransparenz. Stefano Zacchiroli, Professor für Informatik am Polytechnischen Institut in Paris, der ebenfalls an der OSI-Definition mitwirkt, ist sich der Notwendigkeit eines pragmatischen Vorgehens bewusst. Er ist deshalb überzeugt, dass eine vollständige Beschreibung der Trainingsdaten eines Modells das absolute Minimum sei, um es als Open Source zu bezeichnen. "Strengere Definitionen von Open-Source-KI stoßen möglicherweise nicht auf breite Zustimmung."

Letztlich müsse die Community entscheiden, was sie erreichen will, sagt Zacchiroli: "Folgt man einfach der Entwicklung des Marktes, um zu verhindern, dass der Begriff "Open-Source-KI" vereinnahmt wird? Oder versucht man, den Markt zu mehr Offenheit zu bewegen und den Nutzern mehr Freiheiten zu geben?" Doch was ist im KI-Zusammenhang überhaupt der Sinn von Open Source? Es sei fraglich, inwieweit eine Definition von quelloffener KI das Spielfeld einebnen könne, sagt Sarah Myers West, Co-Geschäftsführerin des AI Now Institute. Sie ist Mitverfasserin eines im August 2023 veröffentlichten Papers, in dem die mangelnde Offenheit vieler Open-Source-KI-Projekte aufgezeigt [14] wurde. Darin wird auch hervorgehoben, dass die gigantischen Datenmengen und die notwendige hohe Rechenleistung für das Training kleinen Akteuren Steine in den Weg legen – und zwar unabhängig davon, wie offen die Modelle sind.

Myers West ist überzeugt, dass es auch an Klarheit darüber mangelt, was man mit der Open-Source-Publikation von KI-Systemen zu erreichen hofft. "Geht es um Sicherheit, um die Möglichkeit, akademische Forschung zu betreiben – oder um die Förderung eines stärkeren Wettbewerbs?", fragt sie. "Wir müssen viel genauer wissen, was das Ziel ist, und wie die Öffnung eines Systems die Verfolgung dieses Ziels verändert." Sie befürchtet, dass die OSI diese Diskussion eher meidet. Im bisherigen Entwurf einer Definition werden "Autonomie und Transparenz" als Hauptvorteile genannt, aber Maffulli wollte auf Nachfrage nicht erklären, warum das OSI diese Konzepte für so wichtig hält. Das bislang erreichte Dokument enthält auch einen Abschnitt mit der Überschrift "Fragen, die nicht in diesen Geltungsbereich fallen", der deutlich macht, dass sich die OSI-Definition nicht mit Fragen der "ethischen, vertrauenswürdigen oder verantwortungsvollen" KI befassen will.

Laut Maffulli hat sich die Open-Source-Gemeinschaft in der Vergangenheit darauf konzentriert, den reibungslosen Austausch von Software zu ermöglichen und sich nicht in Debatten darüber zu verzetteln, wofür Software verwendet werden sollte. "Das ist nicht unsere Aufgabe." Doch diese Fragen lassen sich nicht einfach wegwischen, egal, wie sehr man sich im Laufe der Jahrzehnte bemüht hat. Die Vorstellung, dass Technologie neutral ist und Themen wie Ethik "außerhalb des Bereichs" liegen, sei ein Mythos, meint Warso. Sie vermutet, dass dieser Mythos aufrechterhalten werden muss, damit die lose Gemeinschaft der Open-Source-Verfechter nicht zerbricht. "Ich glaube, die Leute wissen, dass [der Mythos] nicht wahr ist, aber es braucht ihn, um voranzukommen."

Außerhalb der OSI haben andere Entwickler einen anderen Ansatz gewählt. Im Jahr 2022 führte eine Gruppe von Forschern die Responsible AI License [15] (RAIL) ein, die Open-Source-Lizenzen ähneln, aber Klauseln enthalten, die bestimmte Anwendungsfälle für KI einschränken. Ziel ist es, so der KI-Forscher Danish Contractor, der die Lizenz mitentwickelt hat, zu verhindern, dass Programmierer KI für Projekte verwenden, die man für "unangemessen" oder "unethisch" halten kann. "Als Forscher würde ich es überhaupt nicht mögen, wenn mein Material in einer Weise verwendet würde, die schädlich für andere ist", sagt er. Und er ist damit nicht allein: Eine kürzlich von ihm und Kollegen durchgeführte Analyse der KI-Hosting-Plattform von Hugging Face [16] ergab, dass 28 Prozent der Modelle bereits RAIL verwenden.

Die Lizenz, die Google seinem Modell Gemma beigefügt hat, verfolgt einen ähnlichen Ansatz. In den Nutzungsbedingungen sind verschiedene verbotene Anwendungsfälle aufgelistet, die als "schädlich" angesehen werden, was das "Engagement für eine verantwortungsvolle Entwicklung von KI" anbetrifft, so das Unternehmen in einem kürzlich veröffentlichten Blogbeitrag [17]. Das Allen Institute for AI wiederum hat ebenfalls seine eigene Auffassung einer offener Lizenzierung entwickelt. Seine ImpACT-Lizenzen [18] schränken die Weiterverbreitung von Modellen und Daten auf der Grundlage potenzieller Risiken ein.

Angesichts der Tatsache, dass sich KI von herkömmlicher Software unterscheidet, ist ein gewisses Maß an Experimentierfreudigkeit mit verschiedenen Graden der Offenheit unvermeidlich und "wahrscheinlich gut für den Bereich", meint Luis Villa, Mitbegründer und Leiter der Rechtsabteilung beim Open-Source-Softwaremanagementunternehmen Tidelift. Er befürchtet jedoch, dass eine Verbreitung von "offenen" Lizenzen, die untereinander nicht kompatibel sind, die reibungsfreie Zusammenarbeit, die Open Source so erfolgreich gemacht hat, zunichtemachen könnte. Dies könnte Innovationen im Bereich der KI verlangsamen, Transparenz verringern und es kleineren Akteuren so erschweren, auf der Arbeit anderer aufzubauen.

Letztlich ist Villa deshalb der Meinung, dass sich die Community auf einen einzigen Standard einigen muss, da die Industrie diesen sonst einfach ignorieren und selbst entscheiden werde, was "offen" bedeutet. Er beneidet die OSI daher nicht. Als die Initiative einst die Definition von Open-Source-Software aufstellte, hatte sie den Luxus der Zeit und wurde von außen kaum beachtet. Heute steht die Künstliche Intelligenz [19] fest im Fadenkreuz sowohl großer Unternehmen als auch der Aufsichtsbehörden.

Wenn sich die Open-Source-Community nicht schnell auf eine Definition einigen kann, werden andere kommen und eine finden, die ihren eigenen Bedürfnissen entspricht. "Die werden dieses Vakuum füllen", sagt Villa. "Mark Zuckerberg wird uns dann allen sagen, was seiner Meinung nach 'offen' bedeutet." Der Mann habe schließlich ein riesengroßes Megafon.

URL dieses Artikels:

https://www.heise.de/-9665378

Links in diesem Artikel:

[1] https://www.heise.de/thema/Open-Source

[2] https://opensource.org/

[3] https://opensource.org/blog/open-source-ai-definition-weekly-update-mar-11

[4] https://www.heise.de/news/Code-Llama-Meta-gibt-KI-fuer-das-Schreiben-von-Code-frei-9284369.html

[5] https://www.heise.de/meinung/OpenAI-ist-jetzt-nicht-mehr-so-open-7622818.html

[6] https://www.heise.de/hintergrund/Tech2go-Podcast-Wie-eine-europaeische-Version-der-KI-GPT-3-aussehen-koennte-6199542.html

[7] https://www.heise.de/news/Hugging-Face-startet-offenes-Robotik-Projekt-9656959.html

[8] https://www.heise.de/news/Bard-ist-tot-es-lebe-Googles-Gemini-9622735.html

[9] https://www.heise.de/news/Ueberraschender-Edelstein-Google-stellt-KI-Modell-Gemma-vor-9634860.html

[10] https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4693148&ref=thestack.technology

[11] https://arstechnica.com/gadgets/2018/07/googles-iron-grip-on-android-controlling-open-source-by-any-means-necessary/

[12] https://www.heise.de/news/AI-Act-Mitgliedstaaten-stimmen-Kompromiss-einstimmig-zu-9617206.html

[13] https://www.heise.de/hintergrund/Wie-sich-Kuenstler-gegen-die-Nutzung-ihrer-Bilder-als-KI-Vorlagen-wehren-7306494.html

[14] https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4543807

[15] https://www.licenses.ai/

[16] https://arxiv.org/pdf/2402.05979.pdf

[17] https://arxiv.org/pdf/2402.05979.pdf

[18] https://allenai.org/impact-license

[19] https://www.heise.de/thema/Kuenstliche-Intelligenz

[20] https://www.instagram.com/technologyreview_de/

[21] mailto:jle@heise.de

Copyright © 2024 Heise Medien

420 Meter misst die Hyperloop-Teststrecke in den Niederlanden.

(Bild: Hardt B.V.)

Sie hat weder Luftschleusen noch Magnetspulen, dafür aber eine Weiche: Was die neu eröffnete Hyperloop-Röhre bei Groningen kann.

In der Nähe von Groningen wurde kürzlich die längste Hyperloop-Teststrecke Europas eröffnet [1]. Dieser Superlativ relativiert sich allerdings, wenn man die absolute Länge betrachtet: 420 Meter. Das reicht nur für Geschwindigkeiten von 75 bis 100 km/h.

Das Besondere an der Stahlröhre des European Hyperloop Center (EHC) [2]: Sie enthält eine Weiche. Weichen sind entscheidend dafür, dass sich nicht nur eine schnelle Punkt-zu-Punkt-Verbindung bauen lässt, sondern ein ganzes Wegenetz. Und bei Magnetschwebebahnen sind Weichen eine notorisch komplizierte Angelegenheit.

Die Weiche des EHC funktioniert ohne bewegliche Teile. "An beiden Seiten der Röhre befinden sich Stahlschienen, die in der Weiche auseinanderlaufen. An den Fahrzeugen gibt es Führungsmagnete für beide Schienen. Je nachdem, welchen Magneten man anschaltet, folgt man der linken oder rechten Spur", erklärt Mars Geuze. Er ist Chief Hyperloop Officer des niederländischen Unternehmens Hardt Hyperloop, das sein System dort als Erstes testen wird.

Die beiden Röhren der Teststrecke laufen y-förmig im spitzen Winkel auseinander. Die Weiche funktioniert also nur in einer Richtung – Züge von einem Arm des Ypsilons können nicht in den anderen Arm abbiegen. Eine T-Kreuzung, auf der man wie bei einem Autobahn-Dreieck von jeder Richtung in jede andere wechseln kann, würde drei solcher y-Weichen erfordern. Wie groß die Weichen ausfallen, hängt von der Geschwindigkeit ab, mit der sie befahren werden sollen. Bei einem Tempo von 200 km/h müssten sie rund 120 Meter lang sein. Bei 700 km/h, wie es Hardt Hyperloop anstrebt, wären es schon 560 Meter.

Wie ein solches Hyperloop-Dreieck in eine Trasse integriert werden könnte, zeigt eine Studie, die Hardt Hyperloop gemeinsam mit der Deutsche Bahn Engineering & Consulting erstellt hat [3]. Es geht dabei um eine Hyperloop-Strecke zwischen Bielefeld und Hannover, mit zwei Abzweigungen bei Hannover.

Ansonsten besteht die Teststrecke des EHC im Wesentlichen aus einer nackten Stahlröhre nebst Vakuum-Pumpen. Luftschleusen gibt es noch nicht, sie sind für ein späteres Upgrade vorgesehen. Das bedeutet: Jedes Mal, wenn ein Testfahrzeug eingesetzt wird, muss die gesamte Röhre acht Stunden lang evakuiert werden. Und solange die Röhre evakuiert ist, gibt es keinen Zugriff auf das Gerät. Die nötige Pumpleistung zur Erzeugung des Grobvakuums von einem Millibar beträgt nach Angaben von Hardt Hyperloop 22 Kilowatt pro Kilometer. Um den Druck zu halten, reiche voraussichtlich 1 kW/km, was aber experimentell noch überprüft werden müsse.

Im Inneren der Röhre sind lediglich einige passive Stahlschienen eingebaut. Alles andere müssen Unternehmen, die ihre Systeme dort testen wollen, selbst einbauen. Beim Konzept von Hardt Hyperloop [6] ist das nicht viel. Es sieht Kapseln für je 40 Passagiere beziehungsweise 12 Europaletten vor, bei denen die Antriebs- und Schwebetechnik im Fahrzeug selbst steckt, nicht im Fahrweg.

Zum Vortrieb interagiert ein Elektromagnet im Fahrzeug mit einer Reihe von Metallpolen an der Schiene, ähnlich wie bei einem Reluktanzmotor [7]. Ins Schweben gebracht werden die Kapseln von Permanentmagneten an Bord, die mit einer laminierten Stahlschiene interagieren. Elektromagneten unterstützen sie dabei und sorgen für die Führung. Die Antriebsleistung bis zur Beschleunigung auf 700 km/h soll 3,3 Megawatt betragen, zur Aufrechterhaltung des Tempos reichen nach Herstellerangaben 665 kW. Den Strom soll eine Batterie mit 640 kWh liefern, die unterwegs induktiv und per Rekuperation aufgeladen werden kann.

42 Wattstunden pro Personenkilometer soll das System laut Hardt Hyperloop verbrauchen (bei 70 Prozent Auslastung auf einer Strecke mit 40 Prozent Beschleunigungs- und Verzögerungsphasen). Ein bis zwei Prozent des gesamten Energiebedarfs gehen dabei auf das Konto der Vakuum-Pumpen.

Zum Vergleich: Ein ICE verbraucht nach Angaben [8] der Deutschen Bahn bei über 200 km/h rund 37 Wh pro Platzkilometer. Bei einer Auslastung von 70 Prozent entspräche das also rund 53 Wh pro Personenkilometer. So groß ist der Unterschied zwischen den Systemen auf den ersten Blick also nicht. Allerdings bezieht sich die Rechnung beim Hyperloop auf ein rund dreimal so hohes Tempo.

Das European Hyperloop Center ist Teil des Hyperloop Development Programs (HDP), einer Public-Private-Partnership mit mehr als 25 Partnern. Das HDP wird unter anderem von der EU-Kommission und der niederländischen Regierung unterstützt. Die EU-Kommission will Hyperloop-Strecken auch in ihr TEN-T [9]-Programm zur Förderung eines effizienten europaweiten Eisenbahnnetzes aufnehmen.

URL dieses Artikels:

https://www.heise.de/-9676370

Links in diesem Artikel:

[1] https://www.heise.de/news/Hyperloop-Forschung-Testcenter-eroeffnet-in-den-Niederlanden-9674751.html

[2] https://www.hyperloopcenter.eu/

[3] https://docs.hardt.global/studies/hanover-bielefeld#321c641b1e2a4f6e8439e463bf195046

[4] https://www.heise.de/bilderstrecke/bilderstrecke_9675296.html?back=9676370;back=9676370

[5] https://www.heise.de/bilderstrecke/bilderstrecke_9675296.html?back=9676370;back=9676370

[6] https://docs.hardt.global/what-is-hyperloop/hyperloop-system-description

[7] https://www.heise.de/hintergrund/E-Mobilitaet-Technik-von-E-Autos-erklaert-7017269.html

[8] https://www.bahn.de/wmedia/view/mdb/media/intern/umc-grundlagenbericht.pdf

[9] https://transport.ec.europa.eu/transport-themes/infrastructure-and-investment/trans-european-transport-network-ten-t_en

[10] https://www.instagram.com/technologyreview_de/

[11] mailto:grh@technology-review.de

Copyright © 2024 Heise Medien

(Bild: Energy.Gov)

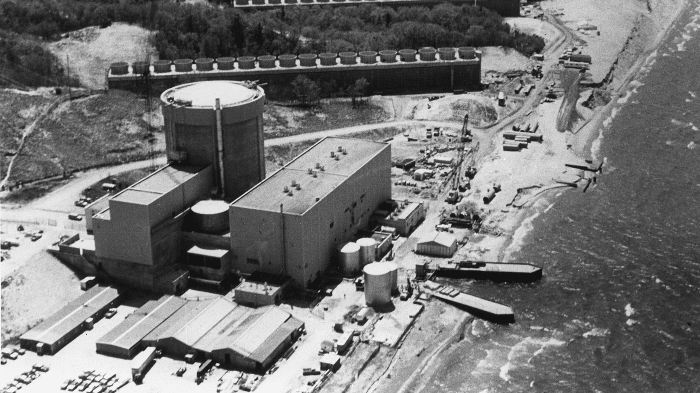

In Deutschland werden regelmäßig Forderungen laut, die Kernkraft wieder anzufahren. Im US-Bundesstaat Michigan gibt es dafür nun ein aktuelles Beispiel.

Einem stillgelegten Kernkraftwerk in Michigan könnte dank eines Milliardenkredits des US-Energieministeriums bald ein zweites Leben eingehaucht werden – und nicht nur in den USA, sondern auch in Europa schaut man ganz genau hin. Sollte das Projekt, das insgesamt 1,4 Milliarden Euro kosten soll, gelingen, wäre es das erste AKW in den Vereinigten Staaten, das eine solche Wiedergeburt erlebt. Das Palisades-Kraftwerk wurde bereits am 20. Mai 2022 stillgelegt, nachdem es 50 Jahre lang CO₂-armen Strom erzeugt hatte. Nun hat es mit Holtec International einen neuen Besitzer – und der ist der Ansicht, dass sich die wirtschaftlichen Bedingungen in den letzten Jahren so stark verbessert haben, dass sich ein Neustart lohnt. Geplant ist er bereits bis Ende 2025.

Ein Erfolg wäre ein wichtiger Meilenstein für die US-Atomkraftwerksflotte. Die 800 Megawatt Leistung der Reaktoranlage könnten dazu beitragen, dass das Land seinen Klimazielen näher kommt. Doch die Wiederinbetriebnahme ist technisch aufwendig. Es reicht nicht, einfach einen Schalter umzulegen, auf dass Palisades [1] wieder in Betrieb gehen kann. Es sind noch jede Menge technische, administrative und regulatorische Hürden zu überwinden, bis es soweit ist. Hier die zentralen Punkte.

Einer der Hauptgründe, warum Palisades überhaupt eine Chance hat, wieder in Betrieb zu gehen, ist, die Tatsache, dass der neue Eigentümer des Kraftwerks dies seit Jahren bereits vorgehabt hatte. "Technisch gesehen stehen alle Sterne gut, damit das Kraftwerk in Betrieb gehen kann", sagt Patrick White, Forschungsdirektor der Nuclear Innovation Alliance, einer gemeinnützigen Denkfabrik der Atomwirtschaft. Die Firma Holtec International rüstet eigentlich Kernreaktoren aus und entsorgt verbrauchten Brennstoff. Zudem legt sie auf Wunsch auch bestehende Anlagen still. Ursprünglich war das auch beim Palisades-Kraftwerk geplant, doch nach dem Kauf entschied man sich um. Die Anlagen wurde nicht zerlegt und dekontaminiert – wie etwa andere Projekte der Firma, darunter das Indian Point Energy Center [2] in New York.

Das ist ein Glücksfall. Denn aufgrund der sich ändernden wirtschaftlichen Bedingungen galt der Weiterbetrieb vieler, vor allem kleinerer Kernkraftwerke, eigentlich als nicht mehr zu rechtfertigen. Diejenigen mit einem einzigen, relativ kleinen Reaktor – wie Palisades – waren am stärksten gefährdet. Und wenn ein Kernkraftwerk einmal abgeschaltet ist, kann es schnell schwierig werden, es wieder in Betrieb zu nehmen. Wie bei einem Auto, das auf dem Hof steht, sagt Experte White, "muss man mit gewissen Beeinträchtigungen rechnen". Wartung und Prüfung kritischer Systeme werden reduziert oder fallen ganz aus. Backup-Dieselgeneratoren zum Beispiel müssten etwa regelmäßig überprüft und getestet werden, während ein Reaktor in Betrieb ist, aber nach der Abschaltung eines Kraftwerks würden sie wahrscheinlich nicht mehr auf die gleiche Weise gewartet, sagt er.

Holtec übernahm Palisades im Jahr 2022, nachdem der Reaktor abgeschaltet und der Kernbrennstoff bereits entfernt worden war. Schon damals gab es Forderungen, den fossilfreien Strom des Kraftwerks im Netz zu halten, sagt Nick Culp, Senior Manager für Regierungsbeziehungen und Kommunikation bei Holtec. Das Unternehmen habe dann schnell umgeschaltet und beschlossen, das Kraftwerk offenzuhalten. Die notwendigen Wartungsarbeiten und die Sicherheitsbuchführung seien weitgehend fortgesetzt worden. "Die Anlage sieht so aus, als wäre sie gestern stillgelegt worden", sagt Culp.

Dennoch ist der Aufwand an Zeit und Ressourcen für die Wiederinbetriebnahme der Anlage nicht so groß. Es sei eher ein Neustart nach einem Tank- oder Wartungsstopp als eine Inbetriebnahme einer vollständig stillgelegten Anlage. Nach Abschluss der Wartungsarbeiten und dem Beladen mit frischem Kernbrennstoff kann der Palisades-Reaktor wieder anlaufen und genug fossilfreien Strom für etwa 800.000 Haushalte liefern.

Dennoch kostet das Projekt viel Geld. Der Bundesstaat Michigan hat in den letzten zwei Jahren bereits 276 Millionen Euro für die Wiederinbetriebnahme des Kraftwerks bereitgestellt. Hinzu kommt nun der an Bedingungen geknüpfte Milliardenkredit des US-Energieministeriums in Washington. Holtec muss dafür bestimmte technische und rechtliche Bedingungen erfüllen, um das Geld zu erhalten, das schließlich mit Zinsen zurückgezahlt werden muss. (Details zu den genauen Bedingungen wurden nicht kommuniziert.)

Die staatlichen Mittel und der Kredit aus Washington werden dazu beitragen, die für den Neustart der Anlage erforderlichen Reparaturen und Aufrüstungsmaßnahmen zu finanzieren. Rund 260 Beschäftigte waren auch nach dem Shutdown weiter im Betrieb und sie freuen sich über ihr regelmäßiges Gehalt. Läuft Palisades wieder im Normalbetrieb, sollen etwa 700 Menschen hier arbeiten. Aktuell sucht Holtec nach neuen Mitarbeitern, die beim Neustart helfen.

Eines der größten Fragezeichen im Zusammenhang mit einer möglichen Wiederinbetriebnahme bleibt allerdings die Genehmigung der Aufsichtsbehörden. Denn die US-Atomaufsicht Nuclear Regulatory Commission (NRC) hat bislang keinen genauen Weg für die Wiederzulassung eines eingestellten Kraftwerkbetriebs formuliert. "Wir betreten hier Neuland", kommentiert Jacopo Buongiorno, Professor für Kerntechnik am MIT, der das Projekt beobachtet.

Hinzu kommt: Palisades hat mit der Abschaltung und der Entnahme des Kernbrennstoffs aus dem Reaktor die Betriebserlaubnis praktisch aufgegeben. Holtec muss der NRC nun detaillierte Pläne vorlegen, aus denen hervorgeht, wie das Unternehmen die Anlage künftig in Betrieb nehmen und sicher betreiben will. Das Vorhaben ist dazu bereits angelaufen: Holtec hat den Antrag zur Wiederzulassung des Betriebs bei der NRC im Oktober 2023 formell eingeleitet und plant nun, die restlichen Unterlagen noch in diesem Jahr einzureichen.

Wenn die US-Aufsichtsbehörde und die örtliche Bürokratie dann grünes Licht gibt, soll Palisades schon bis Ende nächsten Jahres wieder in Betrieb genommen werden. Die Versorgung mit Brennelementen ist bereits gesichert. Hinzu kommt: Holtec hat längst langfristige Abnehmer für die volle Leistung des Kraftwerks gefunden, so Culp. Und es geht um einen langen Zeithorizont: Wenn alles läuft, könnte das Kraftwerk noch bis mindestens 2051 – ganze 80 Jahre nach seiner ursprünglichen Inbetriebnahme – Strom erzeugen. Das sollte sich rechnen.

Und Palisades ist ein echter Trend. Die verstärkte Förderung fossilfreier Stromquellen in den USA, insbesondere der Kernenergie, hat bereits dazu beigetragen, dass die Laufzeit älterer Kraftwerke in den USA verlängert werden konnte. "Die Wiederinbetriebnahme eines Kernkraftwerks stellt eine grundlegende Neuerung bei unserer Unterstützung für sauberen Strom dar", sagt Julie Kozeracki, die für das Kreditprogramm des US-Energieministeriums als Senior Advisor arbeitet.

Angst vor der Kernkraft haben die Menschen mehrheitlich nicht. Laut einer Umfrage des Pew Research Centers [3] aus dem vergangenen Jahr befürworten 57 Prozent der Amerikaner sogar mehr Kernenergie im Land. 2016 waren es nur 43 Prozent. Außerdem stehen immer mehr Mittel zur Verfügung, darunter Steuergutschriften in Milliardenhöhe für Kernenergie und andere CO₂-arme Energieträger – im Rahmen des Inflation Reduction Act (IRA) des Demokraten Joe Biden [4]. Die wachsende staatliche Unterstützung sowie die steigenden Strompreise anderer Quellen tragen dazu bei, dass bestehende Kernkraftwerke viel wertvoller seien als noch vor ein paar Jahren, sagt Kerntechniker Buongiorno vom MIT. "Es hat sich alles geändert."

Doch selbst wenn Palisades mit gutem Beispiel vorangeht – eine Welle wieder angefahrener Kernkraftwerke in den USA steht wohl nicht an. Der Grund: fehlende Voraussicht. "Dies ist ein wirklich seltener Fall, in dem jemand sehr vorausschauend gehandelt hat", sagt White von der Nuclear Innovation Alliance. Es gibt aber eine Lösung dafür: Für andere Kraftwerke, die kurz vor der Stilllegung stehen, wäre es billiger, einfacher und effizienter, den Betrieb einfach zu verlängern.

URL dieses Artikels:

https://www.heise.de/-9674056

Links in diesem Artikel:

[1] https://holtecinternational.com/company/divisions/hdi/our-fleet/palisades-power-plant/

[2] https://www.eia.gov/todayinenergy/detail.php?id=47776

[3] https://www.pewresearch.org/short-reads/2023/08/18/growing-share-of-americans-favor-more-nuclear-power/

[4] https://www.heise.de/hintergrund/Industriepolitik-Unklare-Folgen-bei-den-Milliarden-an-US-Investitionen-7489282.html

[5] https://www.instagram.com/technologyreview_de/

[6] mailto:jle@heise.de

Copyright © 2024 Heise Medien

(Bild: Michal Balada/Shutterstock.com)

Vorhänge im Meer sollen das Abschmelzen polarer Gletscher wie dem Thwaites-Gletscher verzögern. Doch diese lokale Geotechnik ist umstritten.

Er ist das derzeit größten Sorgenkind der Klima- und Polarforscher: der Thwaites-Gletscher in der West-Antarktis. Wie ein Pfropfen verhindert er das Abrutschen des Westantarktischen Eisschildes ins Meer. Doch er ist bereits so stark abgeschmolzen, dass er jetzt offenbar kurz vor seinem Kipppunkt seht. Vielleicht ist dieser Punkt sogar schon überschritten [1], wie Computersimulationen vermuten lassen. Dann wäre sein Verschwinden nicht mehr aufzuhalten, selbst wenn die Erderwärmung aufhören sollte. Löst er sich auf, rutscht das gesamte westantarktische Eisschild hinterher. Die Folge: Der Meeresspiegel steigt in den nächsten Jahrhunderten kontinuierlich um 5,3 Meter. [2]

Die sogenannte Erdungslinie, die Stelle, an der sich ins Meer abfließende Gletscher vom Boden abheben, im Meerwasser aufschwimmen und tauen, verschiebt sich unter dem Thwaites nämlich immer weiter zurück in Richtung Ufer. Das passiert, weil warmes Ozeanwasser die ins Meer reichende Gletscherzunge, das Schelfeis, unterspült und von unten her wegtaut. Die Schelfeisplatte kommt früher ins Schwimmen und bricht ab.

Dem Glaziologen Michael Wolovick kam 2016 die Idee, mit einem am Boden verankerten Vorhang, der von Auftriebskörpern in der Senkrechten gehalten wird, dem warmen Wasser den Zugang zu versperren. Damals arbeitete er noch an der Princeton Universität in New Jersey, inzwischen forscht er in Bremerhaven am Alfred-Wegener-Institut für Polar- und Meeresforschung. Das Vorhang-Konzept verfolgt er allerdings nur noch nebenbei weiter.

Aufgegriffen hat diese Idee John Moore, Glaziologe am Arktischen Zentrum der Universität von Lappland im finnischen Rovaniemi und heute der Hauptverfechter des Plans. Er untersucht seit 2018, wie und ob sich so ein lokales Geoengineering verwirklichen lässt.

Vor einem Jahr veröffentlichten Michael Wolovick und John Moore zusammen mit Bowie Keefer von der Universität von British Columbia in Vancouver eine detaillierte Machbarkeits- und Kostenstudie [3] für einen 80 Kilometer langen Vorhang der vom Meeresgrund in 600 Metern Tiefe 100 bis 250 Meter hoch reicht. Er soll das warme Tiefenwasser zurückhalten, es aber dem kalten ozeanisches Zwischen- und Oberflächenwasser ermöglichen, über den Vorhang hinweg zu strömen. Auch abgebrochene, kleinere und flachere Eisberge können darüber hinweg ins offene Meer treiben.

Dieser Kunststoffvorhang soll mindestens 25 Jahre halten, um dann während der nächsten Jahrzehnte oder auch Jahrhunderte immer wieder erneuert zu werden.

Das Abschmelzen des Thwaites-Gletschers, lässt sich dadurch natürlich nicht verhindern, aber die Menschheit hätte die Chance, Zeit für den Um- und Rückbau der Küstenstädte überall auf der Erde zu gewinnen, ist Moore überzeugt. Er kann sich ähnliches auch für grönländische Gletscher [4] vorstellen.

Billig wäre so eine Geo-Ingenieurskonstruktion zwar nicht, aber um Größenordnungen preiswerter, als die globale Küstenlinie Stück für Stück gegen Überflutungen zu sichern. Das wäre nämlich unvermeidlich, um mit dem Meeresspiegelanstieg durch abgeschmolzene Gletscher mitzuhalten.

Die Installation vor Thwaites würde nach den Berechnungen der Forscher 40 bis 80 Milliarden US-Dollar kosten, der Unterhalt pro Jahr dann ein bis zwei Milliarden. Ein globaler Küstenschutz dagegen käme in jedem Jahr auf ungefähr 40 Milliarden US-Dollar, berechneten die Forscher.

So einleuchtend der Plan, so heikel sind aber die technischen Herausforderungen und so unberechenbar die Reaktionen der natürlichen Umwelt.

Der nächstgelegene Standort für die Herstellung eines solchen Vorhangs wäre Punta Arenas an der Magellanstraße im äußersten Süden Chiles. Von dort müssten leistungsstarke Eisbrecher die großen schwimmenden Module über 2500 Kilometer durch den Ozean südlich von Kap Hoorn und durch die Meereisschollen und Eisberge der vielerorts oft unzugänglichen Amundsen-See vor den Gletscher schleppen. Überdies sind die Taucherarbeiten in diesen Gewässern herausfordernd.

Weitgehend unklar bleibt sogar in der Machbarkeitsstudie, wie der Vorhang die Meeresströmungen und die jahreszeitliche Schichtung der Wasserkörper in der Bucht ändert, in die der Gletscher mündet. Nach Meinung des Polar-Ozeanographen Lars Smedsrud von der Universität Bergen in Norwegen, der in einem Nature-Beitrag [5] zitiert wird, würde die Idee die Erwärmung des Ozeans nicht verhindern, sondern nur die lokale Erwärmung an den Gletscherausläufen reduzieren. "Der Ozean würde sich anderswo stärker aufheizen und dort vielleicht mehr Schaden anrichten."

Bedenken gibt es auch von Biologen. Der Vorhang könnte den Nährstofftransport zwischen Gletscher und Meer blockieren und so Ökosysteme verschieben. Außerdem müsse man damit rechnen, dass der Vorhang bewächst, sagt Meeresbiologe Ulf Riebesell vom Geomar Helmholtz-Zentrum für Ozeanforschung in Kiel gegenüber der Neuen Zürcher Zeitung [6]. "Das schafft ein neues Ökosystem, das da nicht hingehört". Die neuen Organismen würden mit den natürlichen Lebensgemeinschaften um Nahrung konkurrieren.

Schon 2018 hatten sieben namhafte Polarforscher um Twila A. Moon vom National Schnee- und Eis-Datenzentrum der Universität of Colorado in Boulder die Vorhang-Idee scharf kritisiert [7]. Ihr Resümee: "Wir sind der Meinung, dass die begrenzten Mittel, die zur Verfügung stehen, stattdessen dazu verwendet werden sollten, die Ursachen für den beschleunigten Eisverlust zu bekämpfen – nämlich Emissionen und den vom Menschen verursachten Klimawandel."

Auch wenn es wohl noch Jahrzehnte dauern wird, bis so ein Vorhang einsatzbereit ist, begannen Forscher am Zentrum für Klimareparatur der Universität Cambridge [8] schon mit Tests von Vorhangmaterialien in Wassertanks, wie Moore dem Magazin "Business Insider" berichtete [9]. Sobald die Testvorhänge ihre Funktionalität bewiesen hätten, würden man sie ab Sommer 2025 am Boden des Flusses Cam in England verankern und auch hinter Booten herziehen, um ihre Strömungsfestigkeit zu prüfen.

URL dieses Artikels:

https://www.heise.de/-9669311

Links in diesem Artikel:

[1] https://doi.org/10.1038/s41558-023-01818-x

[2] https://doi.org/10.1038/s41558-023-01818-x

[3] https://academic.oup.com/pnasnexus/article/2/3/pgad053/7089571?login=false

[4] https://www.arcticcentre.org/news/Preventing-ice-sheet-collapse-by-seabed-anchored-curtains-in-Greenland-taking-steps-forward/39649/e47ec275-1180-401a-bdd8-800c3009dfab

[5] https://www.nature.com/articles/d41586-024-00119-3

[6] https://www.nzz.ch/wissenschaft/vorhaenge-sollen-gletscher-der-antarktis-vor-warmem-wasser-schuetzen-ld.1776512

[7] https://www.nature.com/articles/d41586-018-04897-5

[8] https://www.climaterepair.cam.ac.uk/refreeze

[9] https://www.businessinsider.com/antarctica-thwaites-doomsday-glacier-melting-collapse-flooding-curtains-2024-3?r=US&IR=T

[10] https://www.instagram.com/technologyreview_de/

[11] mailto:jle@heise.de

Copyright © 2024 Heise Medien

Die Laura Maersk, das weltweit erste mit Methanol betriebene Containerschiff, wird getauft.

(Bild: EU-Kommission)

Bis 2050 will die Schifffahrt klimaneutral werden. Dazu muss die Branche lernen, mit ganz neuen Treibstoffen umzugehen.